“Độ hot” của ChatGPT

Ngày 30/11/2022, OpenAI – đã cho ra mắt sản phẩm ChatGPT, chính thức cho người dùng đăng ký trải nghiệm miễn phí. ChatGPT đã cán mốc con số 100 triệu người dùng vào cuối tháng 1/2023. Theo một nghiên cứu của UBS, ChatGPT đã trở thành ứng dụng tiêu dùng phát triển nhanh nhất trong lịch sử.

Để đạt được con số 100 triệu người dùng, TikTok đã mất khoảng 9 tháng sau khi ra mắt toàn cầu, còn Instagram mất tới 2 năm rưỡi. Trong khi, ChatGPT chỉ mất 2 tháng và chưa ra mắt trên phạm vi toàn cầu.

ChatGPT ra đời như thế nào?

ChatGPT được phát triển dựa trên mô hình Model AI (mô hình trí thông minh nhân tạo). “Model AI” gồm 2 phần: Model (Mô hình) và AI (Trí thông minh nhân tạo – Artificial Intelligence). Quá trình tạo nên Model AI gồm những bước như thu thập dữ liệu, chọn lọc dữ liệu, gắn nhãn dữ liệu và sau đó huấn luyện học máy. Việc dạy AI cơ bản cần tạo tập dữ liệu để chương trình ghi nhớ thông tin. Khi người dùng đặt những câu hỏi tương ứng, AI sẽ lưu lại kiến thức đã được dạy và trả lời giống với những gì đã lưu trữ.

Phương pháp tạo ra AI cơ bản trên đã được nghiên cứu và hình thành từ khoảng năm 1950 nhưng tới hơn 70 năm sau vẫn chưa có nhiều đột phá. Trên thực tế, hàng chục năm qua AI bị chuyên biệt hóa vào các công việc cụ thể như hỗ trợ làm máy bay, mô phỏng chiến đấu, AI trong game… nhưng hầu như không có công ty lớn nào đầu tư cho AI mảng ngôn ngữ. Tới năm 2017 mới có một sự đột phá về công nghệ khiến cho việc huấn luyện AI hiệu quả hơn theo hướng đột biến, nhất là AI ngôn ngữ.

Tháng 8/2017 các nhà khoa học tại Google Brain – đơn vị nghiên cứu chuyên sâu về AI của Google từ 2011 – đã phát minh ra một thuật toán đặt tên Transformer. Transformer là một mô hình học sâu được thiết kế để phục vụ giải quyết nhiều bài toán trong xử lý ngôn ngữ và tiếng nói, ví dụ như bài toán dịch tự động, bài toán sinh ngôn ngữ, phân loại, nhận dạng thực thể, nhận dạng tiếng nói, chuyển văn bản thành tiếng nói.

Dựa vào một số tính năng phân tích tiên tiến, Transformer có thể tận dụng khả năng tính toán song song của GPU và giảm thời gian xử lý đáng kể. Thuật toán mới đã mang tới đột phá trong việc huấn luyện AI ngôn ngữ. Trước đây, loài người muốn dạy AI phải tạo tập dữ liệu huấn luyện sẵn theo cặp Câu hỏi – Trả lời (Labeling Data) như đã đề cập, và máy móc thực chất chỉ ghi nhớ cặp đối đáp mà không “hiểu” được ý nghĩa của câu văn đó, tức “học vẹt” không phải “học hiểu”.

Sau năm 2017, các nhà khoa học chỉ việc đổ dữ liệu chữ vào càng nhiều càng tốt, máy tính sẽ tự tìm hiểu nội dung đưa vào có nghĩa là gì, thay vì con người phải chỉ cho trí tuệ nhân tạo thấy ý nghĩa. Google công khai tài liệu chi tiết về thuật toán Transformer, đồng thời cung cấp quyền sử dụng mở (Open-Source) đối với thuật toán này, nhờ đó toàn bộ giới khoa học làm AI được hưởng lợi từ phát minh của “gã khổng lồ tìm kiếm”, trong đó có OpenAI – một công ty thành lập năm 2015 và không có thành tựu gì nổi bật cho tới sau 2017.

Sau sự kiện trên, những AI ngôn ngữ đầu tiên dựa trên thuật toán mới này ồ ạt ra đời. Tháng 1/2018, OpenAI cho ra đời trí tuệ nhân tạo đầu tiên dựa trên Transformer mang tên GPT-1. GPT viết tắt của Generative Pre-trained Transformer (chương trình Sinh Chữ đã được huấn luyện theo phương pháp Transformer).

Các thế hệ GPT và thước đo độ thông minh của AI

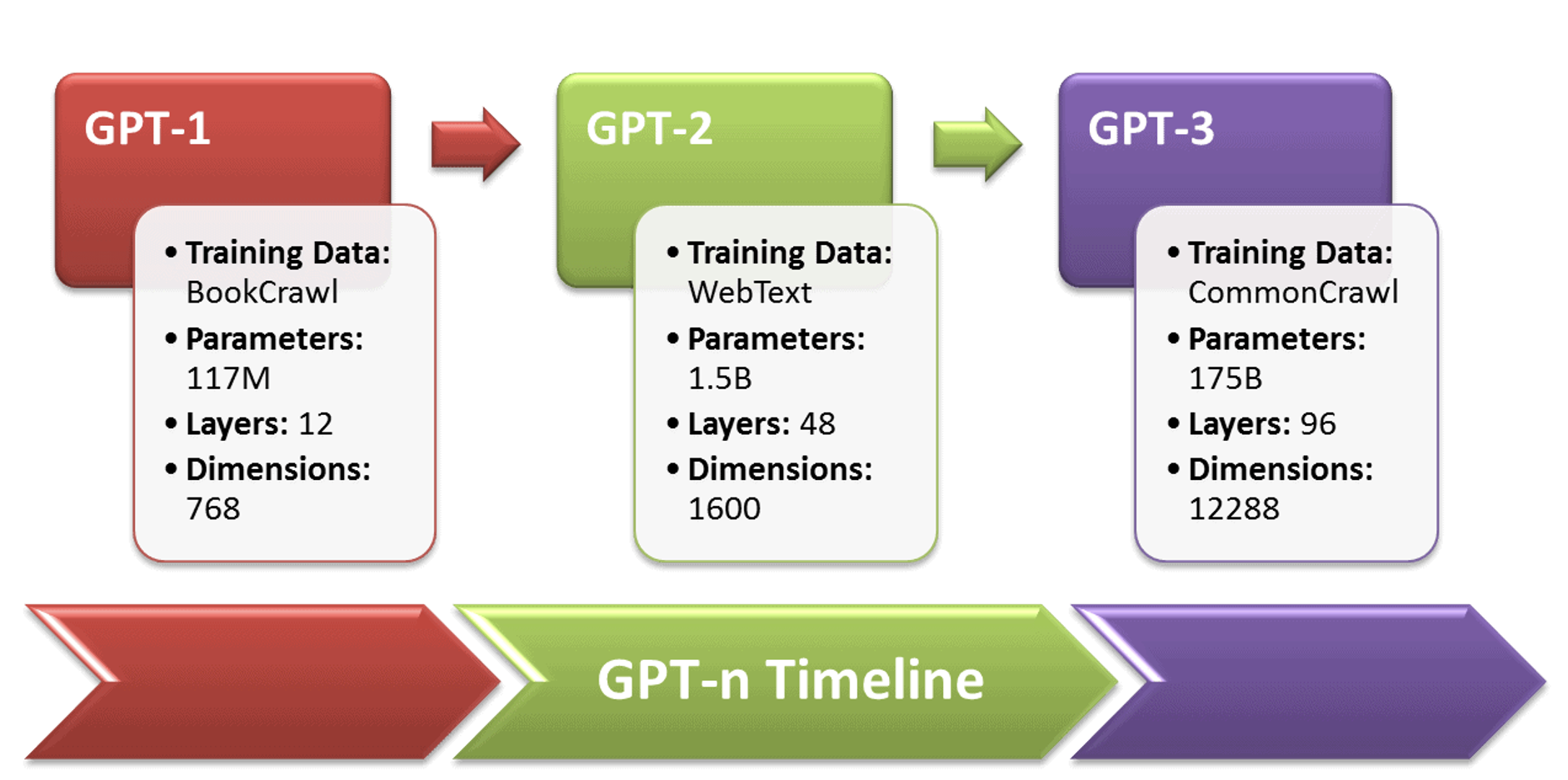

GPT-1 chính là đời đầu của ChatGPT. GPT-1 là một AI khá nhỏ, cả về kích thước cũng như độ phức tạp. Trong thế giới AI ngôn ngữ, các nhà khoa học đo độ phức tạp – tương ứng với mức độ thông minh của AI – bằng đơn vị là Hyper Parameters – Siêu tham số là thước đo xác định AI hiểu văn bản được dùng trong huấn luyện sâu tới bao nhiêu tầng ý nghĩa.

Để huấn luyện GPT, các chuyên gia tại OpenAI thu thập lượng lớn văn bản chữ viết của con người, đa phần từ Wikipedia, Bách khoa toàn thư, các tờ báo lớn và công khai… với khối lượng có thể lên tới vài trăm triệu văn bản. Dữ liệu thu thập xong sẽ “làm sạch”, chọn lọc nội dung trước khi đưa cho AI đọc và bắt đọc rất nhiều lần. Mỗi lần đọc khối dữ liệu, AI lại “nhìn thấy” một tầng ý nghĩa đằng sau những con chữ, càng nhiều lần thì càng nhiều tầng ý nghĩa. Càng nhiều tầng ý nghĩa được AI nhận ra thì trí tuệ nhân tạo càng nhiều Parameters (tham số). GPT-1 có khoảng 117 triệu Parameters.

GPT-2 ra đời năm 2019, cải tiến của GPT-2 chủ yếu là sử dụng tập dữ liệu lớn hơn và dùng mô hình nhiều tham số hơn – đạt 1,5 tỉ Parameters.

Về GPT-1 và GPT-2, hai AI này hầu như không được công chúng biết tới vì hiệu quả sinh chữ chưa thực sự ấn tượng, mức độ hiểu sâu các tầng ý nghĩa đằng sau chữ viết của loài người vẫn còn nông. Ở thời điểm đó, con người vẫn chưa biết sâu bao nhiêu thì gọi là “sâu và hiệu quả” nên các kỹ sư tại OpenAI lại miệt mài dạy cho GPT đào sâu thêm nhiều tầng nữa.

Tháng 5/2020, OpenAI giới thiệu và cho ra mắt GPT-3 – mô hình sinh văn bản mới với phiên bản lớn nhất chứa 176 tỷ tham số. Mô hình này có khả năng thực hiện nhiều tác vụ phức tạp với độ chính xác vượt trội. GPT-3 có thể thực hiện một loạt các tác vụ của xử lý ngôn ngữ tự nhiên mà không cần phải tinh chỉnh trên bất kỳ một tác vụ cụ thể nào. Nó có thể dịch văn bản, trả lời câu hỏi, đọc hiểu, làm thơ và thậm chí là làm các phép tính.

ChatGPT là mô hình ngôn ngữ mới nhất của OpenAI (GPT 3.5) và thể hiện sự cải tiến đáng kể so với người tiền nhiệm GPT-3. Tương tự như nhiều Mô hình ngôn ngữ lớn, ChatGPT có khả năng tạo văn bản theo nhiều phong cách và cho các mục đích khác nhau, nhưng với độ chính xác, chi tiết và mạch lạc cao hơn đáng kể. Nó đại diện cho thế hệ tiếp theo trong dòng Mô hình ngôn ngữ lớn của OpenAI và nó được thiết kế tập trung mạnh vào các cuộc hội thoại tương tác.

Những người sáng tạo đã sử dụng kết hợp cả Học có giám sát và Học tăng cường để tinh chỉnh ChatGPT, nhưng chính thành phần Học tăng cường mới làm cho ChatGPT trở nên độc đáo . Những người sáng tạo sử dụng một kỹ thuật cụ thể có tên là Học tăng cường từ phản hồi của con người (RLHF), sử dụng phản hồi của con người trong vòng đào tạo để giảm thiểu kết quả đầu ra có hại, không trung thực và/hoặc sai lệch.

Mặc dù được đánh giá cao hơn, GPT-3 vẫn mang trong mình những điểm yếu giống với các mô hình ngôn ngữ khác, như sự trùng lặp, thiếu thống nhất trong các đoạn văn dài và thậm chí là mâu thuẫn. Nhưng dù sao, đây vẫn là mô hình ngôn ngữ đồ sộ nhất trong lịch sử loài người tính đến bây giờ.

Chat GPT hoạt động như thế nào?

Nguyên lý hoạt động của ChatGPT có thể hiểu khá đơn giản, ChatGPT nhận một đầu vào (ví dụ, câu hỏi) và sử dụng mạng neural để tìm kiếm trong bộ dữ liệu của nó để tìm câu trả lời phù hợp. Mô hình sử dụng một tập dữ liệu lớn được gọi là kho văn bản (corpus) để học cách tương tác với ngôn ngữ.

Sau khi nhận đầu vào, mô hình sẽ sử dụng các phân lớp của mình để xử lý và chuyển đổi dữ liệu vào một dạng mà nó có thể sử dụng để tìm kiếm trong bộ dữ liệu của nó. Sau đó, mô hình sẽ tìm kiếm trong kho văn bản để đưa ra một câu trả lời phù hợp và trả lời cho người dùng.

Nhược điểm của ChatGPT ?

Độ chính xác thông tin: ChatGPT được huấn luyện trên một lượng lớn dữ liệu, nhưng có thể còn bị sai sót hoặc cập nhật thông tin sai lệch. Các AI được huấn luyện đạt tới mức độ hiểu sâu sắc ngôn ngữ chữ viết của con người, dẫn tới một vấn đề rất nghiêm trọng mà đến hiện tại chưa một nhà khoa học nào làm về AI có giải pháp, chính là tính “đúng” hay “sai” (True or False). Nói cách khác, AI không thể hiểu được đâu là “đúng” và “sai”.

Giới hạn chủ đề: Mặc dù ChatGPT có thể trả lời rất nhiều câu hỏi trên nhiều chủ đề khác nhau, nhưng vẫn còn giới hạn trong một số chủ đề đòi hỏi sự tự nhiên và sáng tạo.

Trách nhiệm: ChatGPT không có trách nhiệm với các thông tin mà nó trả lời và người dùng cần kiểm tra chính xác thông tin trước khi sử dụng.

Phải có Internet: ChatGPT chỉ hoạt động khi có kết nối internet và có thể bị gián đoạn hoặc chậm trễ do sự cố mạng.

Còn tiếp!